Hadoop新子項目HDDS 解決分布式數據存儲瓶頸與擴展性問題

隨著大數據技術的快速發展,Hadoop作為開源分布式計算框架的核心,面臨著數據存儲層長期存在的瓶頸和擴展性挑戰。傳統HDFS在應對海量小文件、元數據管理和跨數據中心復制等場景時效率受限,難以滿足現代企業對高性能、高可擴展性存儲的需求。為了突破這些限制,Apache Hadoop社區推出了新的子項目HDDS(Hadoop Distributed Data Storage),旨在重構分布式數據存儲層,提供更高效的數據處理和存儲支持服務。

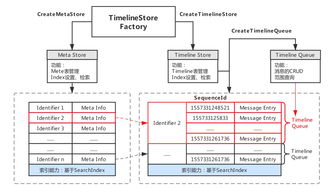

HDDS的核心設計理念是將存儲邏輯與計算邏輯進一步解耦,通過引入分層存儲架構和智能元數據管理,顯著提升數據存取速度和系統擴展性。其關鍵技術包括:

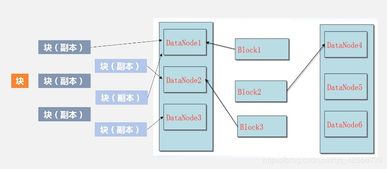

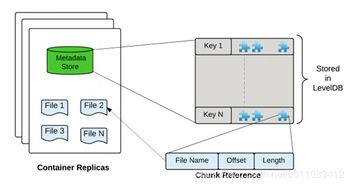

- 容器化存儲模型:將數據塊組織為邏輯容器,減少元數據開銷,支持快速數據定位和遷移。

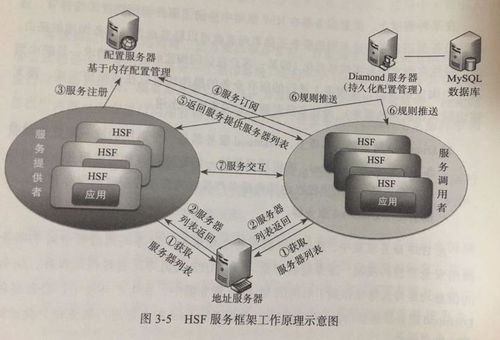

- 動態擴展機制:允許存儲節點按需橫向擴展,無需中斷服務,實現存儲容量的彈性增長。

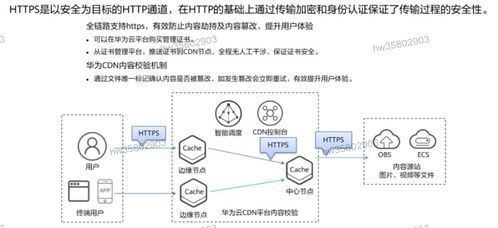

- 多協議支持:兼容HDFS、S3等存儲協議,確保與現有Hadoop生態組件的無縫集成。

- 數據分層與緩存優化:根據訪問頻率自動調整數據存儲層級,結合緩存策略降低I/O延遲。

在信息處理方面,HDDS通過優化數據本地性策略和并行讀寫機制,提升了MapReduce、Spark等計算框架的任務執行效率。同時,其增強的存儲支持服務包括數據壓縮、加密和容災備份功能,為企業級應用提供了可靠的數據管理保障。

實際部署案例顯示,采用HDDS的Hadoop集群在處理PB級數據時,寫入性能提升了約30%,元數據操作延遲降低了50%以上。這不僅解決了傳統Hadoop的存儲瓶頸,還為人工智能、物聯網等數據密集型應用奠定了堅實的基礎。未來,隨著HDDS的持續演進,Hadoop生態系統將更好地支撐云原生和邊緣計算場景,推動分布式存儲技術邁向新的里程碑。

如若轉載,請注明出處:http://www.d9n1w.cn/product/2.html

更新時間:2026-01-19 17:28:50